Negli ultimi mesi (fine febbraio 2024) è nato Groq AI, un nuovo chatbot che ha puntato tutto su una caratteristica, la velocità nelle risposte!

Da non confondere con Grok di Elon Musk (xAI), che però non è per nulla decollata (più marketing che altro), accessibile solo tramite account X Premium e dai benchmark a livello medio risulta nettamente inferiore a ChatGPT, Google Gemini, Mistral AI.

Il sito ufficiale di Groq AI è groq.com, si accede con account Google e proprio sul sito ufficiale (wow.groq.com) compare una provocazione ad Elon Musk:

Hey Elon, It’s Time To Cease & De-grok

Considerato che questi modelli di IA di grandi dimensioni, in versione gratuita non sono particolarmente veloci (specialmente ChatGPT, visto il numero di utenti, in passato finiva anche per bloccarsi o non essere accessibile, oggi è comunque piuttosto lento in alcuni momenti), Groq AI ha puntato sulla velocità e lo ha fatto in modo molto particolare. Partendo dal presupposto che le GPU sono più efficienti rispetto alle CPU per questo tipo di compiti (maggior numero di calcoli in parallelo), è stata sviluppata una nuova soluzione hardware, quella delle LPU (Language Process Unit) tramite la creazione di un nuovo chip, Tensor Streaming Processor (TSP). In questo modo un modello come GPT risulta fino a 10 volte più veloce dato che questa architettura hardware è stata ottimizzata ad-hoc per tale compito.

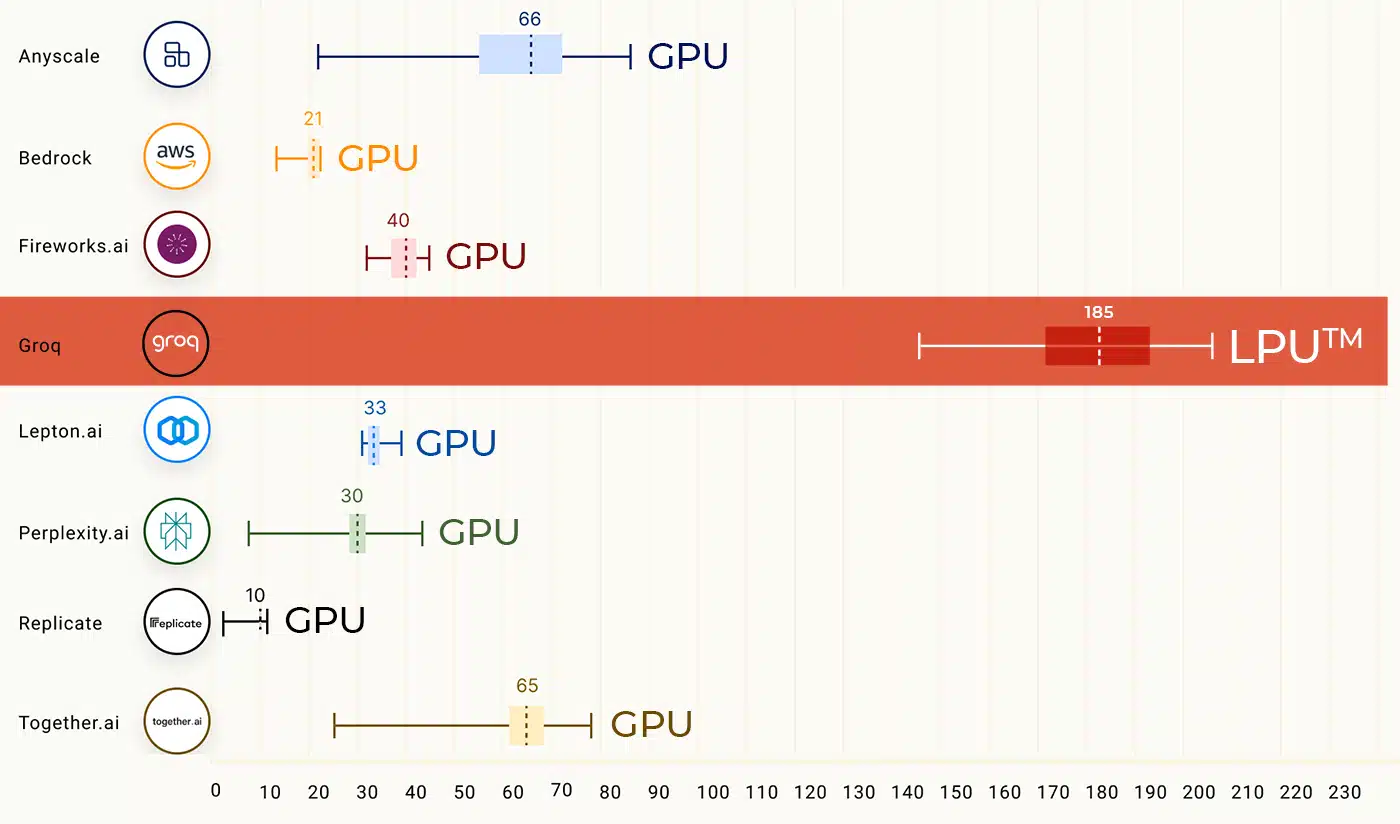

Sul proprio sito, Groq AI ha fin da subito puntato a mettere in mostra i "record di velocità" (Token/s) piuttosto che l'accuratezza, qualità dei risultati nei benchmark. Riguardo alla velocità, abbiamo:

Diciamo che un token corrisponde in media a circa mezza parola. GPT-4 Turbo (a pagamento) raggiunge circa 20 T/s, analogo a Mistral AI, Google Gemini circa 50 T/s, GPT-3.5 (ovvero ChatGPT in versione gratuita) può variare fra 2 e 10 T/s, Groq AI ha già raggiunto i 300 T/s come pubblicato su wow.groq.com.

Non solo velocità, ovviamente vediamo anche l'aspetto legato alla qualità delle risposte! Devo dire che il tool è già più che buono (vista l'enorme crescita e competizione, negli ultimi mesi tutte queste aziende hanno sviluppato e introdotto migliorie, per software sempre migliori, più completi e affidabili). I modelli (LLM) disponibili che possiamo scegliere sono:

- Gemma-7b-It

- Llama3-70b-8192

- Llama3-8b-8192

- Mixtral-8x7b-32768 (a livello generale, è complessivamente il migliore)

Per testare la qualità di risposta, ho preso spunto da una domanda qui, Studio continuità e derivabilitá della funzione; considerato che le domande di matematica sono abbastanza critiche, difficili per questi tool (un tool di IA non ragiona ma fornisce una risposta su base probabilistica pescanndo da un database), la risposta è corretta e il tempo di esecuzione è stato pari a 1,94 secondi (pazzesco!!), con 567,29 T/s, velocità record. Anche ChatGPT mi ha risposto correttamente ma, forse era anche in un momento di traffico intenso, ha impiegato circa un minuto per fornire la risposta completa! Quindi una differenza di tempo davvero enorme. Vediamo uno screenshot, con parte della risposta (a parte la resa delle formule matematiche, non sempre questi tool riescono a rappresentare la simbologia di frazioni, radici, ecc, la risposta è corretta).

Cosa ne pensate? Conoscevate Groq AI? 🙂