NVIDIA, che in passato si occupava di schede video, era solo quella la sua nicchia di mercato, è poi "esplosa" grazie all'Intelligenza Artificiale, diventando fra le tre aziende più grandi al mondo (ad oggi, le sole tre che superano i 3000 miliardi di dollari di capitalizzazione sono NVIDIA, Apple, Microsoft, che talvolta si alternano di posizione). NVIDIA nel corso degli anni ha anche cambiato titolo, motto, "immagine" nel sito web: da "Graphics and GPUs" ora si presenta con il titolo "leader mondiale nel computing con intelligenza artificiale".

Il sito web di NVIDIA (www.nvidia.com) è diventato molto complesso e ricco (se andiamo su "soluzioni" si aprono un'infinità di sottocategorie, oltre alla vendita di prodotti e servizi, anche test di modelli di IA, rendering, simulazioni ingegneristiche online. Talmente complesso e ricco di informazioni che faccio fatica ad orientarmi fra le varie opzioni disponibili 😅 vediamo quindi una panoramica generale, per il resto vi consiglio di navigare e sperimentare voi stessi.

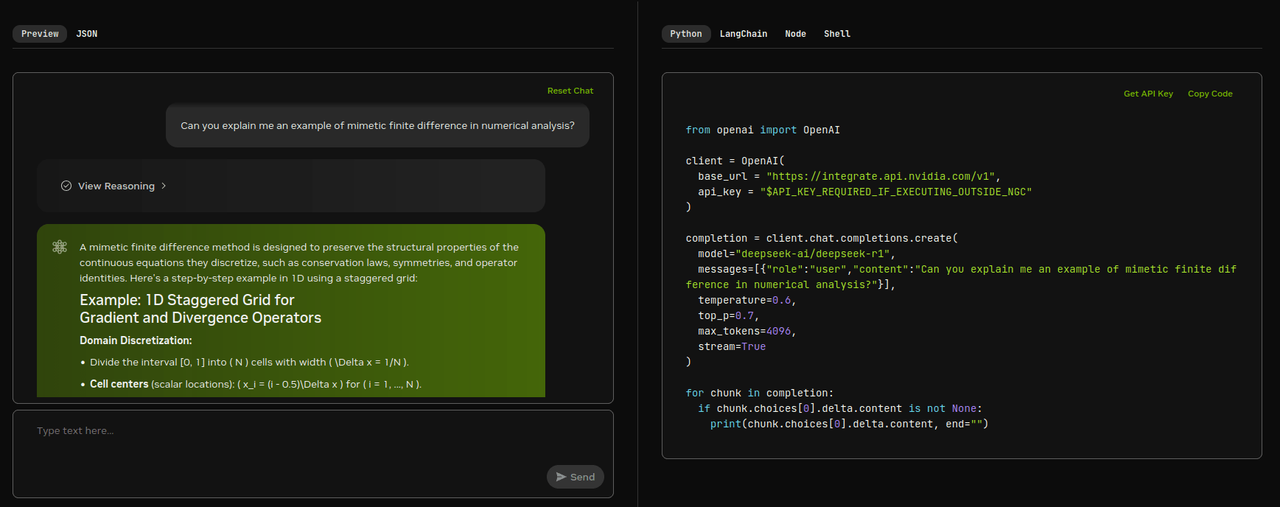

Testare modelli di IA (LLM)

Ad esempio la famosa IA cinese DeepSeek con il modello top deepseek-r1, possiamo accedere al modello da build.nvidia.com. Dove è indicato "type text here" inseriamo il nostro input, interagendo quindi con il chatbot. Il resto della pagina non ci interessa, è per usi più avanzati (codice Python per l'integrazione e impostazione di vari parametri, possiamo lasciare tutto così com'è). Possiamo interagire in italiano, inglese, qualsiasi lingua (da ricordare che in genere i modleli linguistici sono un po' più performanti in lingua inglese). Vediamo quindi un'immagine di esempio.

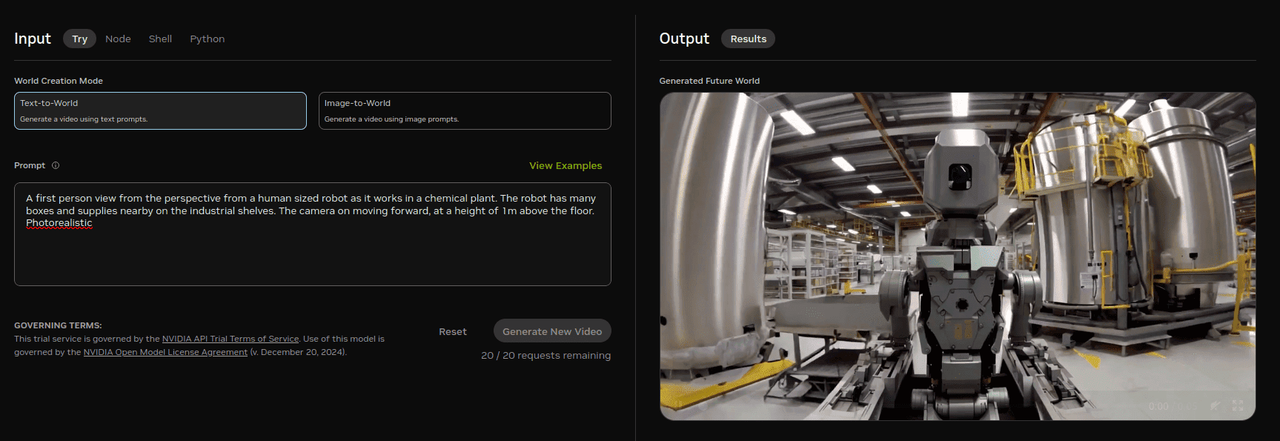

Generazione video IA

Pazzesco, qui con nvidia/cosmos-1.0-diffusion-7b, con il testo presente di default <<A first person view from the perspective from a human sized robot as it works in a chemical plant. The robot has many boxes and supplies nearby on the industrial shelves. The camera on moving forward, at a height of 1m above the floor. Photorealistic>> crea il video di un robot umanoide che si muove all'interno di un laboratorio chimico. Già il fatto di cambiare "a first person view" con "a third person view" in pochi secondi adatta il punto di vista. Vediamo un'immagine di esempio.

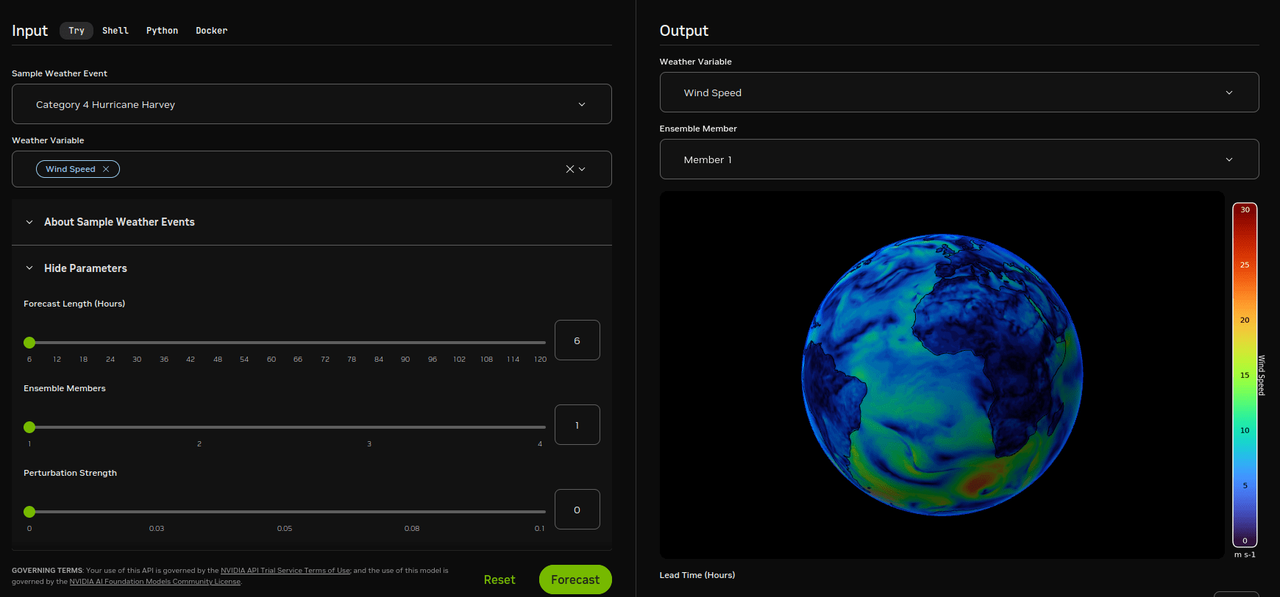

Simulazioni di eventi atmosferici

Qui le impostazioni e calibrazioni possono essere un po' complesse (occorre sapere di cosa si sta parlando), nvidia/fourcastnet si presenta come: <<AI models generate responses and outputs based on complex algorithms and machine learning techniques, and those responses or outputs may be inaccurate, harmful, biased or indecent. By testing this model, you assume the risk of any harm caused by any response or output of the model. Please do not upload any confidential information or personal data unless expressly permitted. Your use is logged for security purposes.>>. Ad esempio selezioniamo "Category 4 Hurricane Harvey" (sull'esempio, data evento 2017/08/23, impatto del danno 125 miliardi di dollari). Vediamo un'immagine di esempio.

Simulazione galleria del vento

Anche qui le impostazioni sono avanzate, se andiamo su nvidia/Build a Digital Twin for Interactive Fluid Simulation, <<Create real-time digital twins by combining accelerated solvers, simulation AI, and virtual environments>>, si tratta di un "digital twin" ovvero rappresentazione digitale di un oggetto o sistema fisico reale, nello specifico un ambiente virtuale che simula il comportamento di un fluido (aria, acqua), attorno ad un oggetto. Per ora ho lasciato le impostazioni di default, vediamo quindi un'immagine di esempio.

Quelli che ho messo sono solamente alcuni esempi di ciò che si trova nel sito di NVIDIA. Non so nemmeno se riuscirò mai a testare tutto, da quanto complesso e dettagliato sia. Cosa ne pensate? Conoscevate già queste novità? Le trovate interessanti? 🙂